ollama:remote_host

本机配备Ollama大模型服务以及提供网页查询交互

第一步:在linux网页机器上运行open-webui,使用下面的docker compose运行一个ollama查询配置服务

具体用法可以查看GitHub的官方网页 https://github.com/open-webui/open-webui

docker-compose.yaml

version: '3'

services:

openwebui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

volumes:

- ./data:/app/backend/data

volumes:

open-webui:

第二部:配置运行显卡本机的ollama让openwebui连接,进行web访问

默认的ollama只能localhost本地访问,要配置给外部访问,需要进行如下配置:

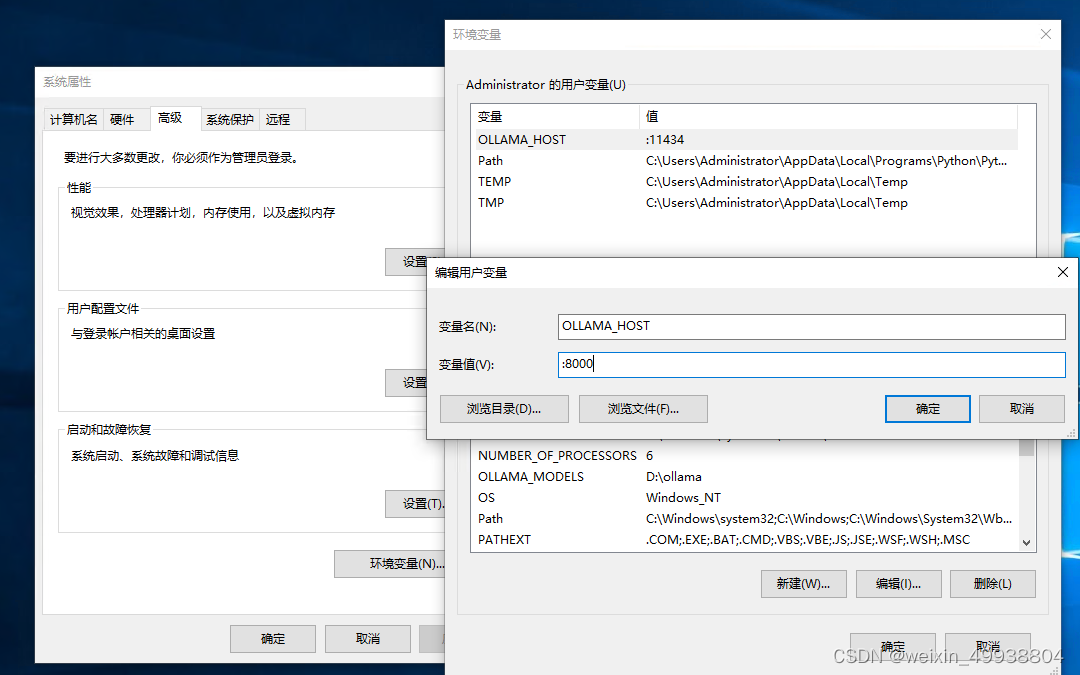

打开系统属性-高级-环境变量-用户变量,然后添加一个名字叫“OLLAMA_HOST”的变量名,值为“:8000”,如下图参考

只填端口不填具体IP地址,指的是监听本机所有IP地址。

参考链接:https://blog.csdn.net/weixin_45131680/article/details/138520336

ollama/remote_host.txt · 最后更改: 由 packingbox